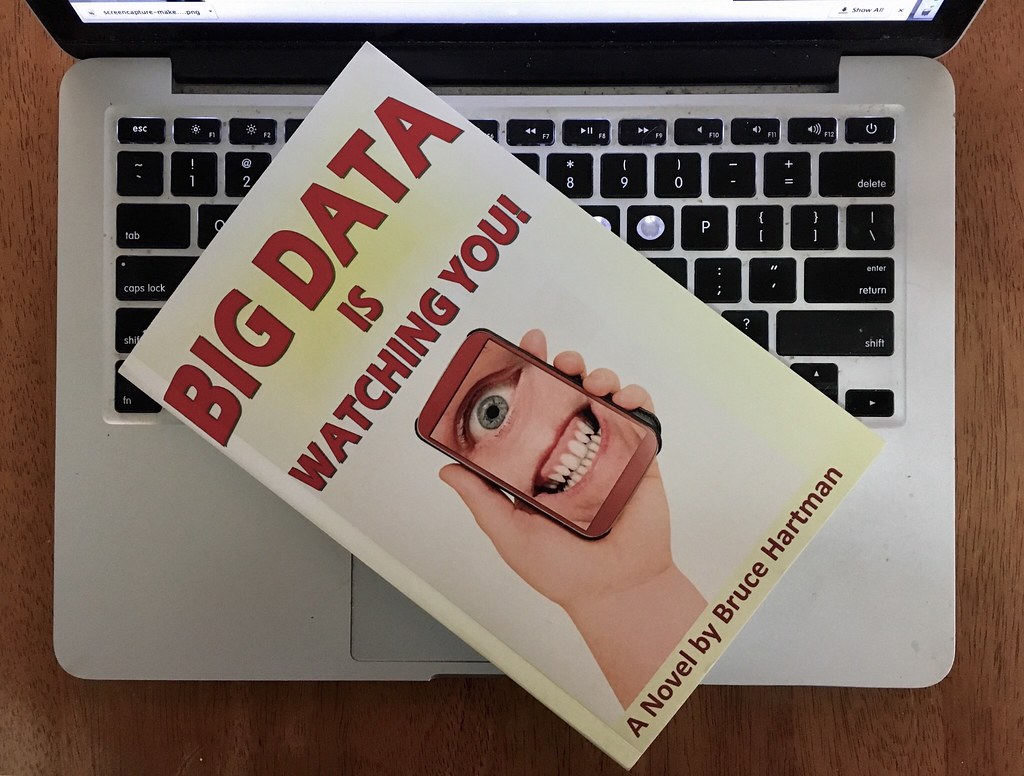

ビッグデータとAIの欠陥

"Who's Watching Big Data?" by cogdogblog is marked with CC0 1.0

中国の人たちの動きを見ていると、民族性って本当にあるんだなと感心します。

特にデータを集めて自分の都合よく人や子孫を扱おうとする意思は、中国の為政者なら忘れられない夢の様です。

中国で遺伝子情報のデータベース化と、カメラによる行動監視、インターネット上の言論監視とそれに基づく「信用度スコア」の設定。

リアル「PHYCO-PASS」の世界を作り上げようとするその執念。

恐れ入りましたと言うしかありません。

その様な情報を集積したものを、「ビッグデータ」といいます。

「ビッグデータ」を集める理由は、現状分析と予測のためです。

たくさんのデータを集積すればするほど、予測精度は上がる。分析の単位(グリッドとか、グラニュラリティ(粒度)とも言います)を細分化すればするほど、細かく正確な分析ができるだろうと言う間違った信念に基づいてデータの集積をし、分析しようとする蒙動です。

敢えて「間違った信念」と言いました。

分析の経験がある程度長い方ならご同意いただけると考えますが、現象には分析に最適な単位というものがあります。細かければ細かいほど良いというものではありません。

「細かい単位で多くのデータで分析すれば、より正しく捉えることができる」という一見正しそうなお題目ですが、物理現象は粒度が変わると見える現象が変わるからです。

人間の心情や行動も集団としてみれば、ブラウン運動の様な物理現象とみなせると私は考えています。それを細かく集めたからと言って、分析に丁度あった様な粒度なら良いのですが、往々にしてそうはなりません。

さらに厄介なことがあります。

「ビッグデータ」を無駄にすることはそんなに難しいことではありません。

所謂「アノマリ」データを多数突っ込めば、「ビッグデータ」は単なる「ゴミの寄せ集め」に成り果て、「ゴミからはゴミしか生まれない」という分析に適さないものにすることができるからです。

何が分析対象として正しい情報で、何が分析対象としてはいけない「アノマリ」なのかは、分析してみないとわかりませんし、恣意的に「アノマリ」として排除したデータが実は一番必要なデータだったりと、「ビッグデータ」は使える対象が限定されるのです。

「ビッグデータ」が使える対象は、下記の様でなければなりません。

1)状態が分析の対象時間を適切に設定すれば、変動パターンが変わらないこと。

2)途中で大きく周へんの条件が変化しないこと。

3)分析対象に外部からの流入や、外部への流出がないこと。(コンタミネーションの排除と言います)

4)意図的な偽情報がないこと

5)収集するデータの集取方法や、単位が一定であること。(非構造化データでも、一定のやり方で一定の範囲を集めるという制限があります)

ところが実際の人間活動は、上記の1)〜3)は変動する要素ばかりです。

全世界の人を「ビッグデータ」に取り込めば良いではないかという人も出るでしょうし、実際に中国政府はそれを狙っているでしょう。

ところがです。

4)だけは排除できないのです。

私もFacebook上など、公的な提出物を除く登録の生年月日は虚偽の情報を載せており、住所なども全部削除するか、虚偽の情報(引越した先を登録しないなど)です。

こういうことを一般的にやられたら、その情報を収集している「ビッグデータ」は、「ビッグガベージ」=巨大なゴミの集まりと化して、分析した結果も、ゴミ(ガベージ)となります。

「ビッグデータ」界隈でいう、「Garbage in, Garbage out」=「ゴミを入れたらゴミしか出ない」、「ごみを入れたら意味のない分析しかできない」という意味ですが、その状態になります。

データディスラプションとか、意図的な偽情報の提供をされ、一定量を超えると集めた情報そのものの意味をなくさせることができる。

これが「ビッグデータ」の限界です。

ですから皆さん!

Facebookなどの簡単に情報を詐取されるものに、本当の生年月日などを入れてはいけません!ごみを仕掛けましょう!

「上に政策有り、下に対策有り」を我々も実践する時です!